【オープンソースモデル】Phi ファミリとは?

Phi は、Microsoft が開発した小型言語モデル(Small Language Model、SLM)のファミリ(シリーズ群)です。

従来の大規模言語モデル(LLM)が強力な AI 機能を実現してきた一方で、その巨大さゆえに動作には莫大な計算リソースが必要でした。

Phi ファミリはこの常識を覆し、はるかに少ないパラメータ数で LLM に匹敵する性能を発揮した革新的なモデル群です。

SLM とは?

SLM は、LLM の小型版と単純に捉えることもできますが、その真価は単なる縮小版というより、より効率的で実用的な AI 活用の選択肢として捉えるべき存在です。

LLM(大規模言語モデル)は非常に強力な能力を持っていますが、以下のような課題もあります。

- 巨大な計算資源が必要(GPU やクラウドの利用コストが高い)

- 計算資源の都合上、デバイスでの動作が困難

- レスポンスが遅いことがある

これに対し、SLM は以下の点で現実的な代替手段として注目されています。

- エッジデバイス(スマートフォン、IoT デバイスなど)でも動作可能な軽量性と高速性

- インフラ負荷が小さく、コスト効率が高い

- ローカル処理も可能なため、クラウドが利用できない場合にも導入が可能

このように、SLM は軽量で扱いやすく、ビジネス課題に直結した導入が可能です。

Phi ファミリの特徴

Phi ファミリは、小型かつ高性能な AI モデルとして、多くの利点を備えています。以下では、Phi を活用することで得られる主なメリットを紹介します。

Phi のメリット (参考:Microsoft AI Cloud Partner Program Japan)

省電力・低リソースで高精度な推論

Phi は小型モデルでありながら、高品質な AI 推論を実現します。必要なメモリや CPU/GPU のリソースが少なくて済むため、電力消費を抑えることも可能です。

Microsoft は Phi ファミリを低コスト・低待機時間で画期的な性能を発揮するモデルと評価しており、計算量を大幅に削減しつつ、非常に高いコストパフォーマンスを実現しています。

インフラや予算が限られているプロジェクトでも、Phi を使えば手軽に高精度な AI 機能を導入可能です。

超高速な応答

Phi はリアルタイム推論に最適化されており、応答時間が非常に短いことが特徴です。

ミリ秒〜秒単位で結果を返すことができ、対話型 AI やゲーム AI などリアルタイム性が求められるアプリケーションにも活用が可能です。

Microsoft 公式からも、リアルタイムの対話や自律システムなど、早いレスポンスが求められるシナリオでの活用に最適と紹介されており、エッジデバイス上で動かすことでネットワーク遅延も回避することができます。

オープンソースとしての自由度と透明性

Phi ファミリはオープンソース(MIT ライセンス)で公開されており、開発者はモデルを無償で自由に導入・利用できます。 これにより、特定のベンダーに縛られずに技術を評価でき、透明性の高い環境で自社のニーズに合わせた開発やカスタマイズを進められるメリットがあります。

具体的なライセンス、入手方法、コストに関する注意点は**「料金体系」セクション**で解説します。

エッジデバイスやモバイル環境での活用性

大規模言語モデル(LLM)がクラウド中心で利用されることが多いのに対し、小型言語モデル(SLM)である Phi ファミリの大きな強みは、エッジデバイスやモバイル環境で直接 AI を実行 できる点にあります。

これは、LLM が抱える課題(高コスト、応答遅延、ネットワーク依存、プライバシー懸念)に対する有力な解決策となります。

Phi ファミリをエッジ環境で活用することには、主に以下のメリットがあります。

- 低遅延・リアルタイム応答: デバイス上で直接処理するため、クラウドとの通信遅延が発生しません。ミリ秒単位の応答が求められる対話システムやリアルタイム制御に適しています。

- プライバシーとセキュリティの向上: 機密性の高いデータをデバイスやローカルネットワークの外に出す必要がなく、安全に処理できます。医療データや個人情報、企業の機密情報などを扱う場合に特に重要です。

- オフラインでの動作: ネットワーク接続が不安定な場所や、接続がない環境(例:トンネル内の車、遠隔地の工場設備、インターネット接続のない機器)でも、AI 機能を継続して利用できます。

- コスト効率: クラウド API の利用料や、大量のデータをクラウドに転送するための通信コストを削減できます。 Phi ファミリは、その軽量性、高速性、電力効率により、スマートフォン、PC、IoT デバイス、産業用コントローラー、車載システムなど、リソースが限られた多様なエッジデバイスへの搭載を現実的なものにします。

Phi ファミリの歴史

Phi ファミリは登場以来、モデルラインナップを拡充してきました。ここでは主なモデル世代とその特徴について整理します。

Phi ファミリのモデル別比較

Phi ファミリはモデルごとに成長しています。Phi-1 が最もレガシーなモデルであり、数が増えるごとに新しいモデルとなります。

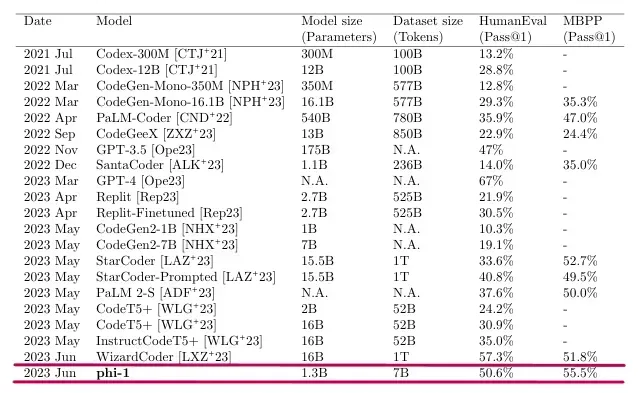

Phi-1 / Phi-1.5:初期モデル

Phi-1 は、小型ながら実用的な性能を持つモデルとして、特にコード生成タスクでの応用が注目されました。Phi-1.5 はその基盤を拡張し、より汎用的な自然言語タスクにも対応できるよう進化しています。

- 13 億パラメータ(1.3B)の Transformer デコーダモデル。

- 詩や物語の生成、メールの下書き、文章要約、Python コードの記述など、多様なタスクに対応。

小型モデルでも実用に足ることを証明する重要なステップとなりました。

Phi-1 の軽量さと性能を示す論文 (参考:Textbooks Are All You Need (Microsoft Research))

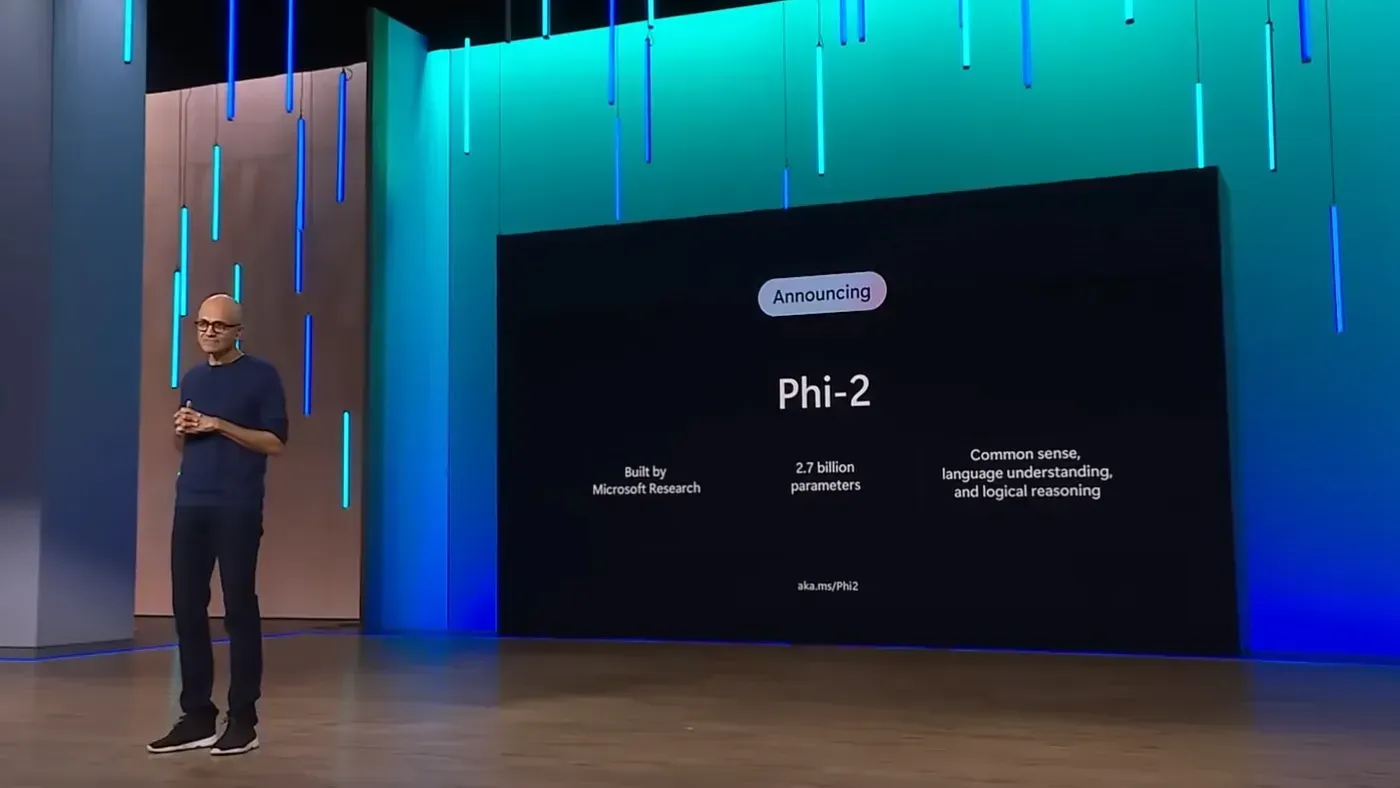

Phi-2:性能と安全性の両立

Phi-2 は、Phi-1 の成果を基に、より高度な推論能力と安全対策を実現しました。実環境での利用を考慮し、コンパクトなモデルサイズながらも安全性を強化しており、幅広いデバイスでの展開が可能となっています。

- 27 億パラメータ(2.7B)にスケールアップ。

- 論理的推論力と安全性(不適切な発話の抑制など)が向上。

- 非常にコンパクトながら、クラウドからエッジまで対応可能。

Phi-2 の発表 (参考:Microsoft)

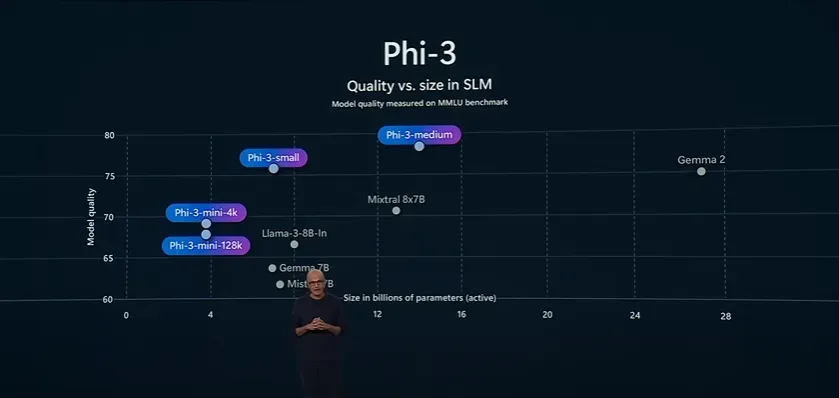

Phi-3:小さくても強力

「Tiny but mighty(小さくても強力)」というキャッチコピーの通り、小型ながら卓越した性能を発揮するモデルとして、小型言語モデルの地位を確立しました。

Phi-3

- 38 億パラメータ(3.8B)ながら、2 倍サイズのモデルを凌駕する性能を発揮。

- コーディングや数学タスクに強み。

- 最大 128K トークンの文脈長に対応、このサイズでの長文処理を実用化した初のモデル。

Phi-3-small / medium

- small:70 億パラメータ(7B) / medium:140 億パラメータ(14B)

- 当時主流だった GPT-3.5 Turbo に匹敵、あるいは上回る性能を示し、MMLU ベンチマークでは Meta の Llama2-7B や Mistral-7B を超えるスコアを記録。

Phi-3.5-mini

- 20 言語以上をサポートする多言語モデルとして、英語以外のユーザーにとっても実用的。

Phi-3.5-MoE

- 総パラメータは42 億パラメータ(42B)相当、実行時には約 6.6Bが活性化され、リアルタイムな応答に対応。

- Microsoft の翻訳モデル開発で培った MoE 技術(Mixture of Experts)を活用。

Phi-3 の発表 (参考:Microsoft)

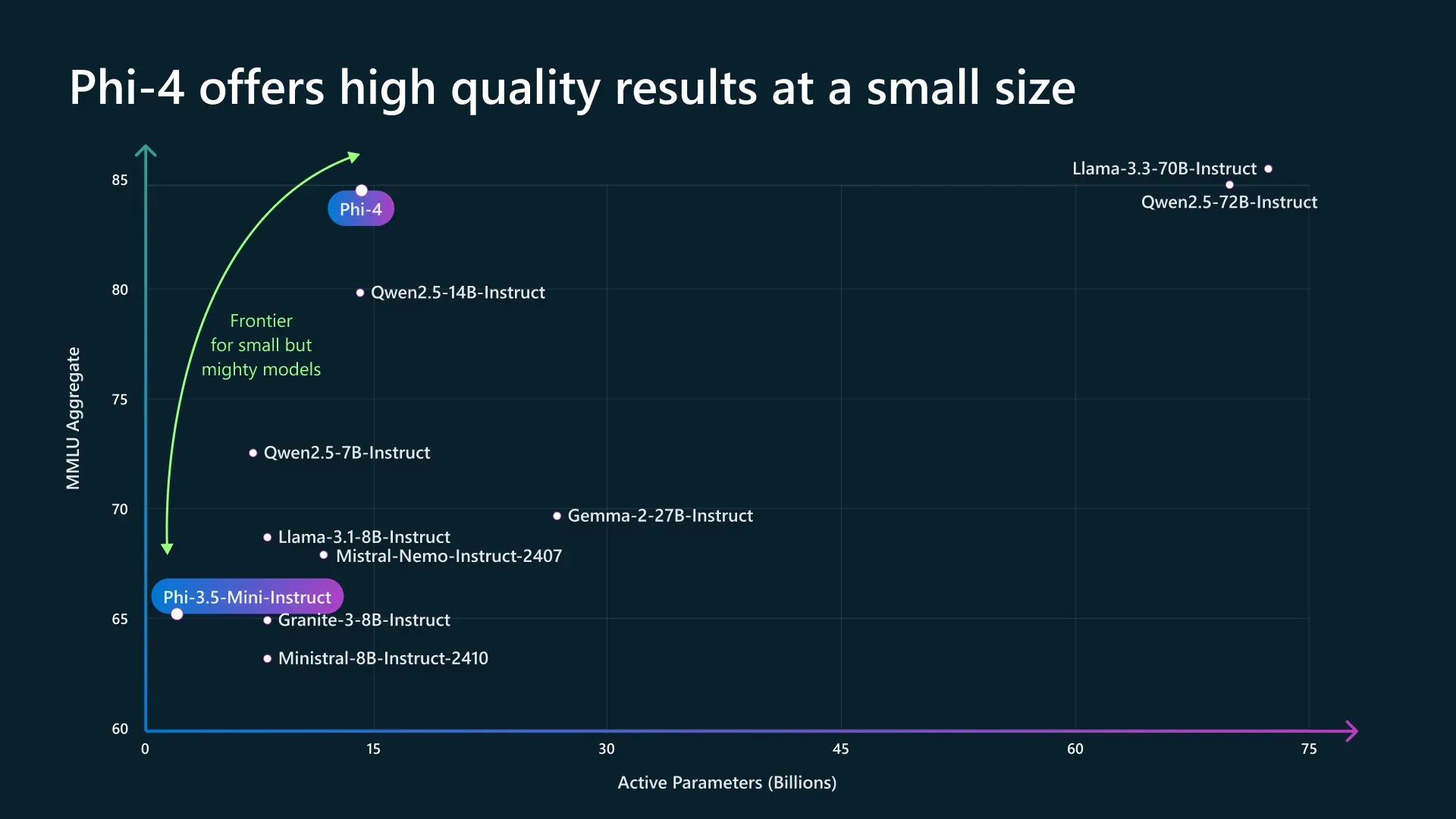

Phi-4:高度な推論とマルチモーダルへの対応

Phi-4 は、最新の高度な推論能力とマルチモーダル対応を特徴としており、外部ツールや多様な入力モダリティと連携できる点が大きな魅力です。またモデルにも複数の種類があります。

実際のアプリケーションにおいて、複数のデータソースを統合して高度なタスクをこなす場面で大いに役立ちます。

Phi-4

- Phi-4:14B パラメータ(140 億パラメータ)モデル。

- 関数呼び出し機能などの新機能が追加され、長文の一貫性ある推論力が向上。

- 外部ツールとの連携にも対応し、エージェント的な応答が可能に。

Phi-4-mini

- 3.8B パラメータ(38 億パラメータ)の軽量版。

- 長文処理の柔軟性を保ちつつ、迅速な応答を実現する設計。

Phi-4-multimodal

- 5.6B パラメータ(56 億パラメータ)のマルチモーダルモデル。

- 音声・画像・テキストの同時処理を実現し、モダリティ統合技術(LoRA など)を活用して、画像キャプション生成や音声 Q&A も可能。

- 競合のGoogle GeminiやMeta InternOmniに匹敵する性能を、小型モデルで実現。

【関連記事】

【Microsoft】Phi-4 とは? 高度な推論を実現する最新 SLM(小型言語モデル)を徹底解説

Phi-4 の性能の進化 (参考:Microsoft)

Phi の使い方

今回は、Azure AI Foundryを用いて、Phi を利用する手順を紹介します。

Azure AI Foundry にアクセスし、対象のプロジェクトを選択します。 その後、左側のサイドバーメニューからサイドバーから、モデルカタログをクリックします。

モデルカタログ

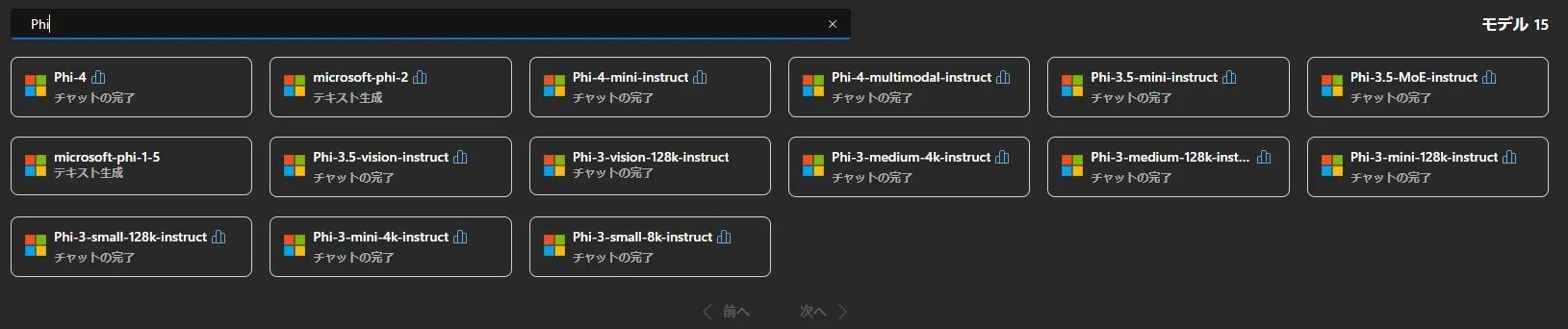

モデルカタログの検索ボックスに「Phi」と入力して検索します。 以下のようにモデル一覧が表示されるので、利用したい Phi のモデル(例: Phi-3-mini、 Phi-4-multimodal など)を選択します。 ※2025 年 4 月現在、「Phi-2」以前のモデルは利用できません

Phiモデル一覧

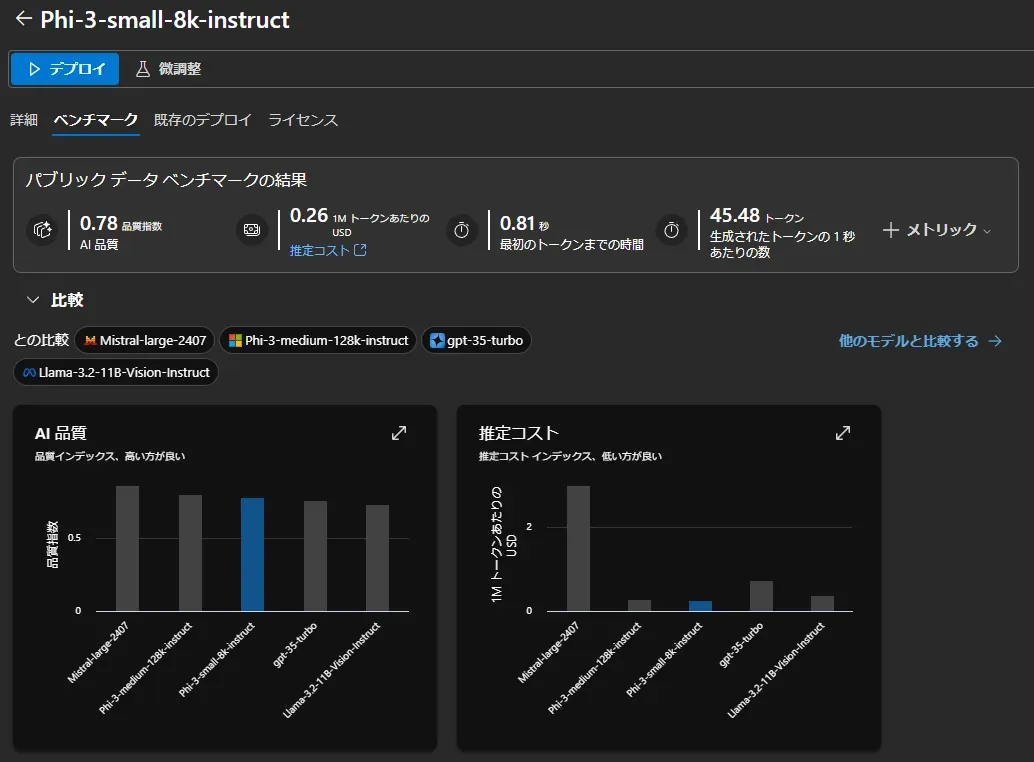

モデルの選択後に、主要なベンチマークによる性能の比較や、詳細な利用料金の確認も可能です。

モデルの詳細確認

デプロイをクリックすることで、すぐに Phi モデルの利用が可能です。 微調整を選択すると、独自のデータに基づいたカスタマイズやチューニングができます。

Phiのデプロイ

デプロイが完了すると、モデルを利用するためのAPI エンドポイント (URI) と認証キーが発行されます。 これらの情報を使って、開発者は SDK(Python など)や REST API 経由でアプリケーションに Phi モデルの機能を組み込むことができます。

また、Azure AI Foundry 内の「プレイグラウンド」機能を使って、コーディングなしでデプロイしたモデルの動作をすぐに試すことも可能です。

Phi の活用事例

ここでは、Phi の利用が適している具体的なユースケースと、その活用ポイントをご紹介します。

1. 医療機関における電子カルテの要約支援と院内情報活用

医療現場では、日々増え続ける医療情報の管理が重要な課題です。特に長文の電子カルテ作成・確認は負担が大きく、また患者データの機密性からクラウド AI の利用には慎重さが求められます。

Phi ファミリは、管理されたローカル環境(院内サーバーや高機能 PC など)で動作させられるため、この課題に対する有効なソリューションとなり得ます。 デバイス上で直接処理することで、患者データを外部に出さずに院内で処理を完結させ、プライバシー保護とデータセキュリティを強化できます。

Phi-4 や Phi-4-multimodal などを活用することで、以下のようなメリットが期待できます。

- カルテ情報の効率的な抽出・要約: 診療記録からの要点抽出、禁忌事項の自動チェック、過去の診療履歴要約などを クラウドとの通信遅延なく迅速化し、医師の診断や記録作成を支援します。

- 高度な情報活用: Phi-4-multimodal のようなモデルを使えば、テキスト情報だけでなく検査画像などもローカル環境で統合的に分析し、診断支援に役立てることも可能です。

これにより、医師やスタッフの業務負担を軽減しつつ、安全な医療情報管理を支援します。

2. 車載システムにおけるオフライン・リアルタイムの対話型ナビゲーション

自動車の運転体験においては、より自然で安全な情報提供が求められます。

従来のナビゲーションは一方的な案内が中心でしたが、Phi のリアルタイム性と自然言語処理能力を活用すれば、以下のようなインタラクティブな対話型ナビゲーションが実現します。

- 自然な音声対話: 「次の角を右?」といった曖昧な質問にも、 Phi が状況を理解しデバイス上で即座に的確に応答します。ネットワーク遅延がないため、ストレスのない対話が可能です。

- オフラインでの安定動作: トンネル内や山間部など通信が不安定な場所でも、ナビ機能音声アシスタント機能が中断されずに利用可能です。

Phi-4-multimodal のようなモデルであれば、カメラ映像なども活用し、デバイス上で状況を総合的に判断して、より高度な情報提供を行うことも期待できます。

3. スマートファクトリーにおけるリアルタイム異常検知と予知保全

製造業では、生産ラインの安定稼働と予知保全が重要課題です。大量のセンサーデータをリアルタイムで分析する必要がありますが、クラウド利用にはコストや遅延、セキュリティのリスクがあります。

Phi ファミリを工場のエッジデバイス(産業用 PC、IoT ゲートウェイなど)に組み込むことで、これらの問題を解決できます。

データを現場で直接処理することで、リアルタイム性とセキュリティを両立します。

例えば、現場でセンサーデータを Phi が直接分析することで、以下の効果が見込めます。

- リアルタイム異常検知: 振動、温度、稼働音、カメラ画像などをエッジデバイス上で低遅延で統合分析し、故障の予兆を早期に発見します。 これにより、計画的なメンテナンスを可能にし、突発的な生産停止リスクを低減します。

- コスト削減とセキュリティ向上: 大量の生データをクラウドに送る必要がなくなり通信コストを削減できます。 また、機密性の高い生産データを工場外部に出さずに処理できるため、セキュリティも向上します。

- 現場での高度な支援: 検知した異常に基づき、Phi が原因分析や対応手順をその場で作業員に提示する(例:保全レポート生成、QA チャット応答)といった応用も可能です。

これにより、計画的なメンテナンスを可能にし、突発的な生産停止リスクを低減します。

4. 小売店舗におけるパーソナライズされた顧客体験の提供

小売業界では、顧客一人ひとりに合わせたサービス提供が競争力の鍵ですが、リアルタイムでの個別対応やプライバシーへの配慮が課題です。

Phi ファミリを店舗内のエッジ AI(カメラシステム、デジタルサイネージ、キオスク端末など)として活用することで、これらの両立を目指せます。 データをデバイス内で処理することで、プライバシー保護とリアルタイム性を確保します。

店舗内のカメラ映像やセンサーデータを Phi がローカルで分析し、以下のような応用が考えられます。

- 匿名化された行動分析: 顧客の顔などを特定せず、匿名化された属性や行動をデバイス上で推定します。個人情報はクラウドに送信しないため、プライバシーに配慮した分析が可能です。

- リアルタイムな情報提供: 分析結果に基づき、その場で遅延なくデジタルサイネージに最適なクーポンを表示したり、近くのスタッフに関連情報を通知したりできます。

これにより、プライバシーを守りながら顧客満足度を高め、購買促進につなげることが期待できます。

Phi ファミリの料金体系

Phi ファミリのモデルは MIT ライセンスのオープンソースで公開されており、モデル自体の取得・利用に料金は発生しません。

ただし、利用する形態によって費用が発生するケースがあります。以下に無料の利用範囲と有料の利用範囲を整理します。

【無料利用の範囲】

- モデルファイルの取得 Hugging Face 等からのダウンロード。

- Azure AI モデルカタログでの利用 Azure AI モデルカタログでのモデル選択、デプロイ操作、基本的な検証(プレイグラウンド等)。

【有料利用の範囲】

- API 利用 Azure OpenAI Service のエンドポイントを呼び出して推論実行する場合は、トークン数に応じた従量課金制が適用 (具体的な単価は後述)。

- セルフホスト/エッジ実行 自身で用意した環境でモデルを実行する場合 → インフラ費用(サーバー、デバイス等)が自己負担。

つまり、モデルは無料でも、Azure のマネージド API サービス利用や、自身で用意する実行環境にはコストがかかります。

以下では、標準モデルと Finetuning(ファインチューニング)モデルの API 料金体系をご紹介します。

1. モデル利用料金

学習済みの標準モデルを API 経由で呼び出して利用する場合の、入力トークンと出力トークンに基づいた料金です。

モデル名 | コンテキスト長 | 入力 (1,000 トークンあたり) | 出力 (1,000 トークンあたり) |

|---|---|---|---|

Phi-3-mini | 4K | $0.00013 | $0.00052 |

Phi-3-mini | 128K | $0.00013 | $0.00052 |

Phi-3.5-mini | 128K | $0.00013 | $0.00052 |

Phi-3-small | 8K | $0.00015 | $0.0006 |

Phi-3-small | 128K | $0.00015 | $0.0006 |

Phi-3-medium | 4K | $0.00017 | $0.00068 |

Phi-3-medium | 128K | $0.00017 | $0.00068 |

Phi-3.5-MoE | 128K | $0.00016 | $0.00064 |

Phi-4 | 128K | $0.000125 | $0.0005 |

Phi-4-mini | 128K | $0.000075 | $0.0003 |

Phi-4-multimodal, text and image | 128K | $0.00008 | $0.00032 |

Phi-4-multimodal, audio | 128K | $0.004 | $0.00032 |

2. ファインチューニング料金

モデルを自社データでトレーニング(微調整)する場合の料金です。 学習時、ホスティング(モデルの展開)時、およびファインチューニング済みモデル利用時にそれぞれコストが発生します。

モデル名 | コンテキスト長 | 学習 (1,000 トークンあたり) | ホスティング (1 時間あたり) | 利用時 入力 (1,000 トークンあたり) | 利用時 出力 (1,000 トークンあたり) |

|---|---|---|---|---|---|

Phi-3-mini | 4K | $0.003 | $0.80 | $0.00013 | $0.00052 |

Phi-3-mini | 128K | $0.003 | $0.80 | $0.00013 | $0.00052 |

Phi-3.5-mini | 128K | $0.003 | $0.80 | $0.00013 | $0.00052 |

Phi-3-medium | 4K | $0.003 | $0.80 | $0.00017 | $0.00068 |

Phi-3-medium | 128K | $0.003 | $0.80 | $0.00017 | $0.00068 |

Phi-3.5-MoE | 128K | $0.003 | $0.80 | $0.00016 | $0.00064 |

Phi-4 | 128K | $0.003 | $0.80 | $0.000125 | $0.0005 |

Phi-4-mini | 128K | $0.003 | $0.80 | $0.000075 | $0.0003 |

表の参考ページ:Announcing new Phi pricing, Empowering Your Business with Small Language Models

※本記事の掲載の情報は、2025 年 3 月発表時点の料金体系です。変更される可能性があるため、最新情報はAzure 公式の価格ページまたは公式ブログでご確認ください。

まとめ

本記事では、Phi を導入するメリット、モデルの進化、活用事例や料金体系まで詳しく解説しました。

Phi ファミリは、小型ながら高性能という新しい AI モデルの可能性を切り開きました。

技術者にとってはエッジデバイスで動く軽量モデルとして、意思決定者にとってはコスト効率に優れた AI ソリューションとして、非常に魅力的な選択肢となっています。

今後も Microsoft は Phi を進化させ続け、より多彩な機能と一層の高性能化を実現していくでしょう。Phi を活用することで、高効率な AI の力を取り入れてみてください。

東京エレクトロンデバイスは、企業の AI 活用・Azure の企業導入をサポートしています。 お気軽にご相談ください。